카카오, 멀티모달 LLM ‘허니비’ 마침내 출격

컨텐츠 정보

- 74 조회

- 목록

본문

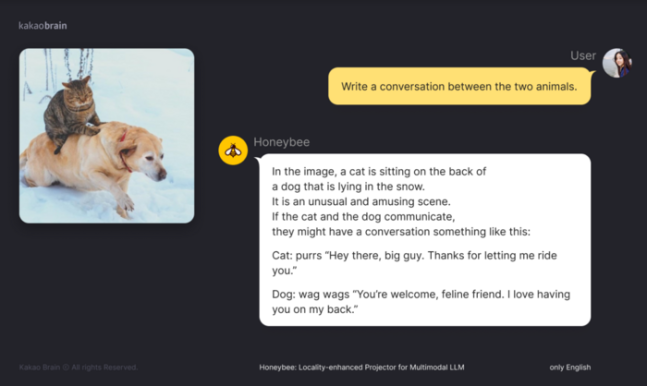

예를 들어 ‘허니비’에 ‘농구 경기 중인 두 명의 선수’ 이미지와 함께 ‘왼쪽 선수는 몇 번 우승했나요?’라는 질문을 영어로 입력하면, ‘허니비’가 입력된 이미지 내용과 질문을 종합적으로 이해하고 답변을 생성해낸다.

그 결과, ‘MME’, ‘MMBench’, ‘SEED-Bench’ 등의 벤치마크(성능 실험)에서 모델이 공개된 타사 MLLM 대비 최고 성능을 달성했다는 것이 카카오브레인측 설명이다. 특히 지각 능력과 인지 능력을 평가하는 ‘MME’ 벤치마크에서는 2800점 만점 중 1977점을 받았다.

또 관련 논문 ‘허니비: 멀티모달 LLM을 위한 로컬리티 강화 프로젝터(Honeybee: Locality-enhanced Projector for Multimodal LLM)’은 지난해 논문 공개 사이트 ‘아카이브(arXiv)’에 게재된 바 있다. 카카오브레인은 “이미지 데이터를 처리해 딥러닝 모델이 더 효과적으로 학습하고 이해할 수 있도록 돕는 기술”이라며 “시각 프로젝터(Visual projector)가 사전 훈련된 비전 인코더와 대규모 언어 모델(LLM)을 연결하는 데 중요한 역할을 하며, 이를 통해 시각적 이해를 깊게 하면서 LLM의 능력을 활용할 수 있다”고 설명했다.

카카오브레인은 ‘허니비’의 MLLM 특성에 따라 이미지를 입력하고 텍스트로 질문하면 답변 생성 및 사용자와의 상호작용이 가능해 향후 효과적인 교육 및 학습 보조 도구로 사용될 것으로 기대하고 있다.

카카오브레인 김일두 각자 대표는 “허니비 모델의 추론을 가능하게 하는 코드도 깃허브에 공개했으며, ‘허니비’를 활용한 각종 서비스 확장을 고려 중”이라며 “더욱 발전된 AI 모델 확보를 위해 끊임없이 연구⋅개발할 것”이라고 덧붙였다.

관련자료

댓글 0

등록된 댓글이 없습니다.

토토커뮤니티 토토 먹튀 안전놀이터 정보 제공 - 토토갤러리

토토커뮤니티 토토 먹튀 안전놀이터 정보 제공 - 토토갤러리

.gif)